Deep learning (dyb læring): Definition, neurale netværk og anvendelser

Dyb læring: Lær om neurale netværk, principper og praktiske anvendelser inden for billed-, tale- og mønstergenkendelse — fra teori til praksis.

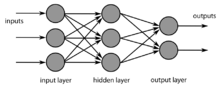

Dyb indlæring (også kaldet dyb struktureret indlæring eller hierarkisk indlæring) er en form for maskinindlæring, som oftest anvendes sammen med visse former for neurale netværk. Som med andre former for maskinlæring kan læringssessioner være uovervågede, semiovervågede eller overvågede. I mange tilfælde er strukturerne organiseret således, at der er mindst ét mellemliggende lag (eller skjult lag) mellem inputlaget og outputlaget.

Visse opgaver, som f.eks. at genkende og forstå tale, billeder eller håndskrift, er lette at udføre for mennesker. For en computer er disse opgaver imidlertid meget vanskelige at udføre. I et neuralt netværk med flere lag (med mere end to lag) bliver de behandlede oplysninger mere abstrakte for hvert lag, der tilføjes.

Deep learning-modeller er inspireret af informationsbehandlings- og kommunikationsmønstre i biologiske nervesystemer; de adskiller sig på mange måder fra de strukturelle og funktionelle egenskaber i biologiske hjerner (især den menneskelige hjerne), hvilket gør dem uforenelige med neurovidenskabelige beviser.

Hvordan dyb læring fungerer

Grundidéen i dyb læring er at kæde mange simple, parametrede beregningselementer (ofte kaldet neuroner) i flere lag, således at netværket lærer et hierarki af repræsentationer. Et typisk lag udfører en lineær beregning efterfulgt af en ikke-lineær aktiveringsfunktion (fx ReLU, sigmoid eller softmax i output). Træningen sker typisk ved at minimere en fejl- eller tabfunktion (loss) over mange eksempler ved hjælp af gradientbaserede optimeringsmetoder som stokastisk gradient descent (SGD) og varianter (Adam, RMSProp).

Vigtige komponenter i træningsprocessen omfatter:

- Forward pass: beregning af netværkets output for et input.

- Backpropagation: beregning af gradienter for at opdatere vægtene.

- Batch-størrelse, læringsrate og epochs: hyperparametre der styrer læringens hastighed og stabilitet.

- Regularisering: teknikker som dropout, tidlig stop og vægtforfald (weight decay) for at undgå overfitting.

Neurale netværksarkitekturer

Der findes mange arkitekturer, hver velegnet til forskellige typer data og opgaver:

- Fuldstændigt forbundne netværk (MLP): grundlæggende feedforward-netværk til tabeller eller simple funktioner.

- Konvolutionsnetværk (CNN): særligt effektive til billed- og videobehandling pga. lokal forbindelse og vægtdeling.

- Rekurrente netværk (RNN) og LSTM/GRU: designet til sekvenser (f.eks. tale og tekst), men delvist erstattet af transformer-baserede modeller.

- Transformers: arkitekturer baseret på selvopmærksomhed (self-attention) som har revolutioneret naturlig sprogbehandling og nu også anvendes til billeder og multimodale opgaver (fx BERT, GPT, Vision Transformers).

- Generative modeller: herunder GANs (Generative Adversarial Networks), VAEs (Variational Autoencoders) og nyere diffusion-modeller til billed-, lyd- og tekstgenerering.

Træning, data og ressourcer

Dyb læring er data- og beregningsintensivt. Store, velannoterede datasæt forbedrer ofte ydeevnen markant. Nogle centrale punkter:

- Data: kvalitet og mangfoldighed er kritisk. For mange opgaver bruges store offentlige datasæt eller syntetisk data; annotering kan være dyrt.

- Fortræning og transfer learning: prætrænede modeller (fx på ImageNet eller store tekstkorpora) finjusteres ofte til specifikke opgaver, hvilket reducerer behovet for store lokale datasæt.

- Beregning: moderne træning bruger GPU'er og TPU'er for at accellerere matrixoperationer. Effektivisering (pruning, kvantisering, distillation) reducerer beregnings- og hukommelsesbehov.

- Evaluering: bruger metrikker som nøjagtighed, præcision, recall, F1, BLEU, ROUGE mv., samt benchmarks som ImageNet eller GLUE for sammenligning mellem modeller.

Anvendelser

Dyb læring anvendes i en lang række domæner og har muliggjort praktiske fremskridt:

- Billed- og videogenkendelse: ansigtsgenkendelse, medicinsk billeddiagnostik, objektdetektion og segmentering.

- Tale og lyd: talegenkendelse, talegenerering (TTS), lydklassifikation og støjreduktion.

- Naturlig sprogbehandling (NLP): maskinoversættelse, tekstgenerering, spørgsmål-svar-systemer og sentimentanalyse.

- Autonome systemer: vejledning og beslutningstagning i autonome køretøjer og robotter.

- Anbefalingssystemer: personaliserede anbefalinger i e-handel og streamingtjenester.

- Generativ indholdsskabelse: billeder, lyd, video og tekst via GANs, diffusion-modeller og store sprogmodeller.

- Medicinsk forskning: sygdomsdiagnose, lægemiddeldesign og patientdataanalyse.

Begrænsninger, risici og etik

Selvom dyb læring er kraftfuldt, er der vigtige begrænsninger og risici:

- Bias og fairness: modeller kan gentage og forstærke skævheder i træningsdata, hvilket kan føre til diskriminerende resultater.

- Forklarbarhed: dybe netværk er ofte sorte bokse; manglende gennemsigtighed udfordrer tillid og regulering.

- Sårbarhed: modeller kan være følsomme over for adversariale angreb eller ændringer i datafordelingen (distribution shift).

- Privatliv: træning på følsomme data kan rejse databeskyttelsesspørgsmål; teknikker som federated learning og differential privacy adresserer nogle af disse bekymringer.

- Miljø og ressourceforbrug: træning af store modeller kan kræve betydelig energi, hvilket har miljømæssige konsekvenser.

Relationen til biologiske hjerner

Deep learning er løst inspireret af biologiske nervesystemer, men forskellene er store. Neurale netværk i maskiner er forenklede matematiske modeller: de efterligner kun visse koncepter (fx vægte og koblinger) uden at fange den komplekse organisation, stofskifte, plasticitet og dynamik i biologiske hjerner. Af samme grund er mange moderne dybtlæringsresultater ikke direkte forenelige med fund fra neurovidenskaben, og feltet udvikler sig ofte uafhængigt af biologisk forskning.

Praktiske værktøjer og vejen videre

Udviklere og forskere bruger bibliotekker som TensorFlow og PyTorch, samt økosystemer til dataforberedelse, modeludrulning og overvågning. Fremtidige tendenser inkluderer:

- Større multimodale og foundation-modeller, der kan håndtere tekst, billeder og lyd i samme arkitektur.

- Effektivitetsteknikker: modelkomprimering, sparsificering og hardware-acceleratorer.

- Bedre metoder til robusthed, forklarbarhed og fairness for at gøre systemerne mere pålidelige og ansvarlige.

Samlet set er dyb læring et hurtigt udviklende område med vidtrækkende anvendelser og betydelige etiske, tekniske og praktiske udfordringer. Forståelse af både de tekniske mekanismer og konsekvenserne i den virkelige verden er afgørende for ansvarlig brug og videre innovation.

Et neuralt netværk med flere lag.

Spørgsmål og svar

Spørgsmål: Hvad er dyb indlæring?

A: Deep learning er en type maskinlæring, der anvender neurale netværk til at behandle information, og som ofte er organiseret med mindst ét mellemliggende (skjult) lag mellem input- og outputlagene.

Q: Hvad er de forskellige former for læringssessioner, der anvendes i dyb læring?

Svar: Deep learning kan organiseres i uovervågede, semiovervågede og overvågede læringssessioner.

Spørgsmål: Hvilke opgaver er lette for mennesker, men vanskelige for computere at udføre?

A: Opgaver som f.eks. at genkende og forstå tale, billeder eller håndskrift er lette for mennesker, men vanskelige for computere at udføre.

Spørgsmål: Hvad sker der med oplysningerne, når de behandles i et flerlags neuralt netværk?

A: I et flerlags neuralt netværk bliver de behandlede oplysninger mere abstrakte for hvert lag, der tilføjes.

Spørgsmål: Hvad er deep learning-modeller inspireret af?

Svar: Deep learning-modeller er inspireret af informationsbehandling og kommunikationsmønstre i biologiske nervesystemer.

Spørgsmål: Hvordan adskiller dybe indlæringsmodeller sig fra egenskaberne i biologiske hjerner?

A: Deep learning-modeller adskiller sig på mange måder fra de strukturelle og funktionelle egenskaber ved biologiske hjerner, især den menneskelige hjerne, hvilket gør dem uforenelige med neurovidenskabelige beviser.

Spørgsmål: Hvad er en anden betegnelse for dyb læring?

A: Dybdegående læring er også kendt som dyb struktureret læring eller hierarkisk læring.

Søge